すべてのWEBページには定期的にGoogleクローラーが巡回しているわけですが、巡回される必要のないページ(ログインページなど)を巡回されないように設定しておく必要があります。

そこで設定することになるのが「robots.txtファイル」です。Wordpressの場合は、「Yoast SEO」の機能で簡単に設定できるので、私のおすすめです。

本記事の内容

Googleクローラーの巡回が必要のないページ(例えばログインページや編集用のページ)をGoogleクローラーの巡回から外すことで、検索インデックスへの登録をなくして、サイトの信頼度を高めていくことができます。本記事では、Wordpressの人気プラグイン「Yoast SEO」の機能でrobots.txtを編集する方法について解説します。

目次

- 目的:WordPressの「Yoast SEO」でrobots.txtを編集したい

- なぜ、robots.txtの編集が必要なのか

- 「Yoast SEO」でrobots.txtを編集する方法

- 「robots.txt」をGoogleの「robots.txtテスター」で確認する方法

- まとめ

1.目的:WordPressの「Yoast SEO」でrobots.txtを編集したい

ここでやりたいことは、WordPressのSEOプラグインで人気の「Yoast SEO」で、robots.txtを編集することです。

この「robots.txtファイル」は、Googleのクローラーに巡回して良いものとダメなものを判別する情報を与える重要なファイルです。

たとえば、Wordpressにログインするページのアドレスが検索されると困りますよね。または、編集をするページが検索されても困ります。

実際には、編集ページはパスワードでロックされているのでクロールできないのですが、もしそうしたアドレスがGoogleのインデックスに登録されると、「クロールしたいのに出来ない!」というエラーが上がってしまいます。

こうした、巡回して欲しくない(つまりGoogleのインデックスへの登録を避けたいもの)をrobots.txtへ書き込むことで、巡回を制限することができます。

しかし、この「robots.txtファイル」は、WEBページのトップページにおく必要があり、WordpressではFTPサイトでその場所に行っても『あれ?ない?』と見つけることができません。

実は、WordPress ではrobots.txt にアクセスがあった場合に自動生成されるファイルなのです。

そのため、WordPress では「仮想 robots.txt」なんて呼ばれます。

ここでは、実際にrobots.txtファイルを作るということですが、テキストファイルで作って、FTPでアップロードは大変なので、WordPressのSEOプラグインで人気の「Yoast SEO」でお手軽にやりたいという趣旨です。

2.なぜ、robots.txtの編集が必要なのか

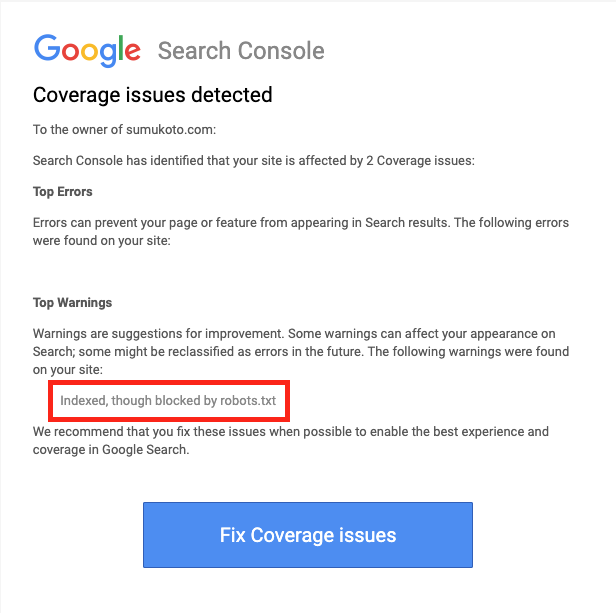

ときどき、Google Search Consoleからこんなメッセージが届きます。

んん!なんだこれは?Warningはいやですね。

これは、「Googleの検索インデックスに登録されているのに、クロールできないよ」という警告です。

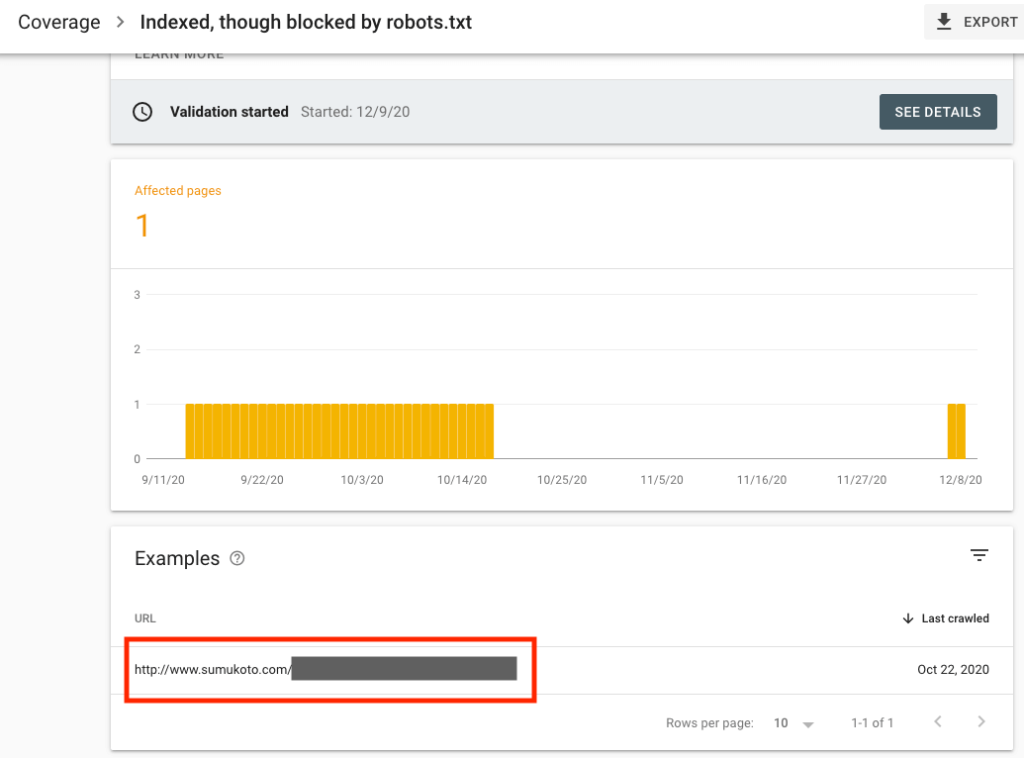

Google Search Consoleをみると、こんな感じで警告上がっています。

赤枠で囲ったところが、クロールできないサイトですね。

つまり、私のrobots.txtでの登録が遅くて、本来クロールして欲しくないページが、なぜかGoogleインデックスに登録されてしまっているのです。

この警告は、Googleの検索インデックスからなくなるまで待たないといけません。

それはなんかいまいちな状況ですね。

ということでいろいろ調べると、robots.txtでの指定をしっかりしないといけないことに気づかされます。

別にこれが何かスパムを生んだりとか人に迷惑をかけるわけではないのですが、WarningやErrorの発生はサイトの信頼度を落とすので、これを避けるほうが良いです。

WordPressでは基本は、ログインページがクロールされないこと、あとは編集ページがクロールされなければOKです。あとは、必要の応じて個別に設定します!

個人のウェブサイトでも、robots.txtをしっかり編集しておくことが重要と思います。

3.「Yoast SEO」でrobots.txtを編集する方法

やり方を見てみましょう!結構簡単です。

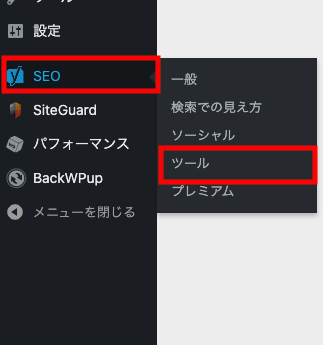

WordPressのメニューを表示します。

まず、前提として「Yoast SEO」が入っていないといけません。インストールしていない方は、プラグインからインストールしておきましょう。

「SEO」の「ツール」をクリックします。

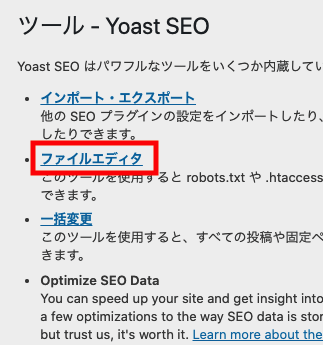

「ファイルエディタ」をクリックします。

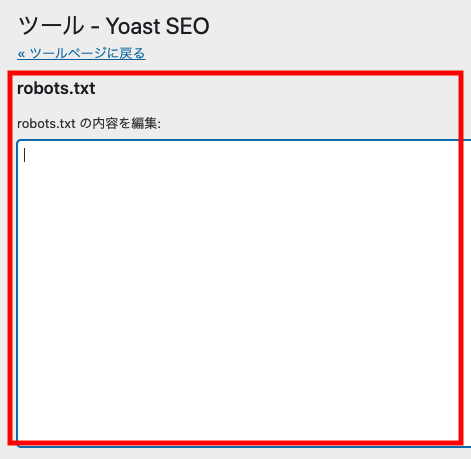

ここに、「robots.txt」がありますので、こちらに入力していきます。

書き込む内容は、以下の通りです。

User-agent: *

Disallow: /wp-login.php

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://xxxxxx.jp/sitemap.xml一応、現在の内容を確認しておいても良いですね。

それをコピーして編集しても良いと思います。

https://sample.com/robots.txt上記のように打ち込むと、現在の内容を確認できます。(sample.comのところは、自分のアドレスに変えてください。)

その内容をまずは、コピーしてもOKです。

設定項目

- User-agent: * :これは必須なのでこのままにします。

- Disallow: /wp-login.php :これでログインページをクロールしないように指定します。ちなみに、ログインページを既に変えている場合には必要ありません。

- Disallow: /wp-admin/ :これで編集ページを一括してクロールしないようにします。

- Allow: /wp-admin/admin-ajax.php :このままにします。

- Sitemap: https://xxxxxx.jp/sitemap.xml :こちらは、サイトマップのページです。サイトマップを構築してる場合は、こちらに必ず指定しておきましょう。

設定のヒント

Disallow: /*?p=*こんな指定もあり!です。

これは、以下のような状況を避ける設定です。

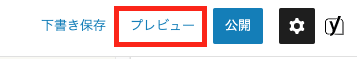

WordPressをやっていて、編集中にプレビューをすると、

https://xxxxxx.jp/?p=1051&preview=true&_thumbnail_id=1111こんなアドレスが自動的にできてしまいます。

そして、このサイトがGoogleのクローラーにかかってしまい、インデックスに登録されることもあるのです。(それは私ですが・・・)

そうした自体を無くすのが以下の指定です。

Disallow: /*?p=*こうすると、編集中のプレビュー画面のクローラーの指定を外すことができます。

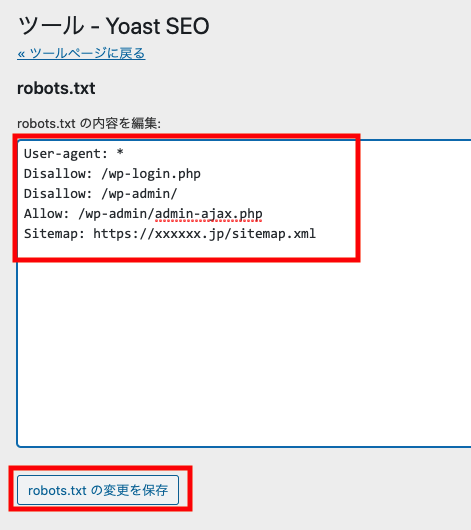

全体的な「robots.txtファイル」のその場合はこうなります。

User-agent: *

Disallow: /wp-login.php

Disallow: /wp-admin/

Disallow: /*?p=*

Allow: /wp-admin/admin-ajax.php

Sitemap: https://xxxxxx.jp/wp-sitemap.xml

完成したら、robotx.txtに書き込みます。

その後、「robots.txtの変更を保存」をクリックします。

これで、完成です。

そんなに難しいことはないです。

「robots.txt」をGoogleの「robots.txtテスター」で確認する方法

その後、Googleのrobots.txtテスターで必ず、チェックをするのをおすすめします。

このテストは、Google Search Consoleに登録していないとできないので、登録がまだの人は、まずGoogle Search Console登録しましょう。

登録がOKとなったら、以下のサイトに移動します。

無事に移動できれば、こんな画面が出てきます。

まず、内容を確認しましょう。

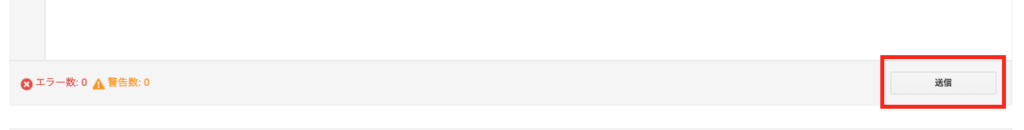

まず、エラー数と警告数がないことを確認してください。

もしあった場合は、robots.txtの記述に誤りがありますので、直してからやり直します。

ここの画面は、「robotx.txtファイル」は表示のみで、変更はできないので気をつけましょう。

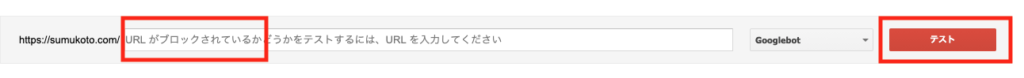

そしたら、次にURLがブロックされているかのテストをします。

任意のURLを入れます。そして、テストボタンを押します。

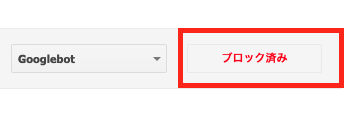

ブロックされるべきURLなら、以下のように表示されます。

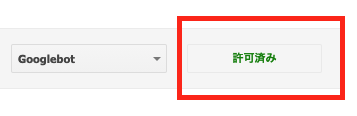

ブロックされてはいけないURLなら、以下のように表示されます。

しっかり確認をしてOKであれば、最後に「送信ボタン」をクリックしてGoogleにrobots.txtが更新されたことを知らせてあげます。

以上で、robots.txtテスターは終了です。

4.まとめ

本記事では、Yoast SEOでrobots.txtファイルを編集する方法について解説しました。これにより、robots.txtが原因となるSearch Consoleがエラー回避されると思います。設定していない人は必ずやっておきましょう。